信息技术

科技日报记者 张梦然

《自然》23日发表的研究报道了一种能效为传统数字计算机芯片14倍的人工智能(AI)模拟芯片。这一由IBM研究实验室开发的芯片在语音识别上的效率超过了通用处理器。该技术或能突破当前AI开发中因算力性能不足和效率不高而遇到的瓶颈。

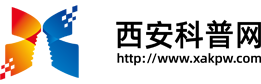

研究者拿着14纳米模拟AI芯片。

图片来源:雷恩·莱文/《自然》网站

随着AI技术的崛起,对能源和资源的需求也随之上升。在语音识别领域,软件升级极大提升了自动转写的准确率,但由于在存储器与处理器之间移动的运算量不断增加,硬件无法跟上训练和运行这些模型所需的数以百万计的参数。研究人员提出的一个解决办法是,使用“存内计算”(CiM,或称模拟AI)芯片。模拟AI系统通过直接在它自己的存储器内执行运算来防止低效,而数字处理器需要额外时间和能源在存储器和处理器之间移动数据。模拟AI芯片预计能极大提升AI计算的能效,但对此的实际演示一直缺乏。

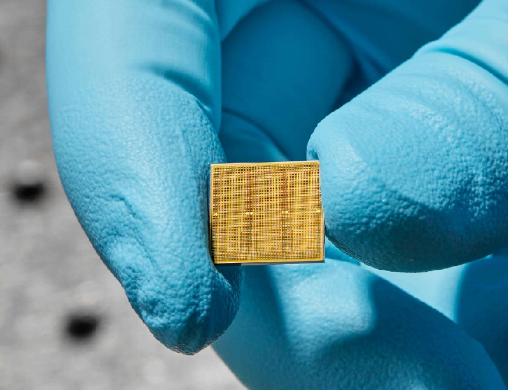

在检测板上的14纳米模拟AI芯片。

图片来源:雷恩·莱文/《自然》网站

研究团队此次开发了一个14纳米的模拟芯片,在34个模块(tile)中含有3500万个相变化内存单元。研究团队用两个语音识别软件在语言处理能力上测试了该芯片的效率,这两个软件分别是一个小网络(谷歌语音命令)和一个大网络(Librispeech语音识别),并在自然语言处理任务上与行业标准进行对比。小网络的性能和准确率与当前的数字技术相当。对于更大的Librispeech模型来说,该芯片能达到每秒每瓦12.4万亿次运算,系统性能估计最高能达到传统通用处理器的14倍。

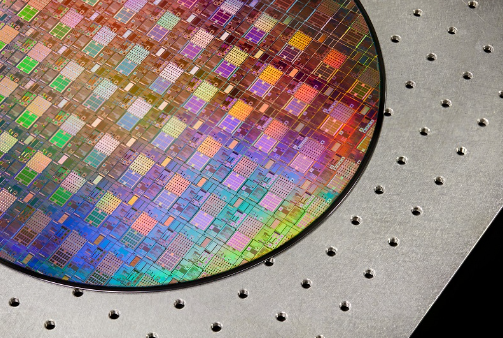

用来制造模拟AI芯片的300毫米晶圆。

图片来源:雷恩·莱文/《自然》网站

研究团队总结道,该研究在小模型和大模型中同时验证了模拟AI技术的性能和效率,有望成为数字系统的商业可行的替代选择。

【我们尊重原创,也注重分享。版权原作者所有,如有侵犯您的权益请及时联系,我们将第一时间删除。分享内容不代表本网观点,仅供参考。】